KI-Haftung, Datenschutz und Strafrecht: Die neue Verantwortungsmatrix

Juristische Expertise

- Cybercrime & Krypto-Betrug

- AI & Zukunftsrecht

- Steuerrecht & Steuerstrafrecht

- Gesellschaftsrecht, Immobilienrecht & Zivilrecht

- Datenschutz & Digitalrecht

KI-Haftung, Datenschutz und Strafrecht: Die neue Verantwortungsmatrix

KI-Haftung, Datenschutz und Strafrecht verschmelzen. Wer haftet, wenn Algorithmen irren oder diskriminieren?

KI, Haftung und Strafrecht – Drei Systeme, ein Risiko

Was auf anwalt.de noch als Frage begann, zeigt sich in der Praxis längst als Realität:

Künstliche Intelligenz ist nicht mehr bloß ein Werkzeug, sondern eine juristische Herausforderung – ein System, das zugleich Daten verarbeitet, Entscheidungen trifft und Verantwortlichkeiten verschiebt.

Die Schnittstelle zwischen Datenschutz (Art. 82 DSGVO), Strafrecht (§ 42 BDSG, § 15 StGB) und zivilrechtlicher Haftung entwickelt sich zu einem der sensibelsten Rechtsgebiete der kommenden Jahre.

Denn KI-Systeme können heute Daten analysieren, Muster erkennen und Handlungen auslösen, die – wenn sie fehlerhaft oder diskriminierend sind – reale rechtliche Folgen haben: Bußgelder, Schadensersatz, ja sogar strafrechtliche Ermittlungen.

Die zentrale Frage lautet daher nicht mehr, ob, sondern wie juristische Verantwortung verteilt werden muss, wenn menschliche Entscheidungen von Algorithmen beeinflusst oder ersetzt werden.

Zivilrechtliche und strafrechtliche Haftungsachsen

Die klassische Verschuldenshaftung stößt im Kontext autonomer Systeme an ihre Grenzen.

Wenn ein KI-System Schaden verursacht, ist selten eindeutig feststellbar, wer konkret verantwortlich war – der Entwickler, der Betreiber oder der Anwender?

Deshalb wird auf europäischer Ebene über Gefährdungshaftungsmodelle diskutiert, bei denen eine Haftung ohne Verschulden greifen soll.

Ziel ist ein stärkerer Opferschutz, doch dieses Modell birgt die Gefahr einer Innovationshemmung, wie Wolf-Georg Ringe und Tim Kuhmann betonen (JZ 2025, 227 ff.).

Parallel wird das Produkthaftungsrecht reformiert:

Die EU-Produkthaftungsrichtlinie und die geplante KI-Haftungsrichtlinie schließen Lücken für algorithmische Systeme, indem sie eine erweiterte Dokumentations- und Offenlegungspflicht für Hersteller und Betreiber einführen (Rüsing, Jura 2025, 843 ff.).

Damit wird Transparenz zum Dreh- und Angelpunkt jeder künftigen Verteidigungs- oder Haftungsstrategie.

Strafrechtliche Verantwortlichkeit im digitalen Umfeld

Auch im Strafrecht rücken algorithmische Prozesse zunehmend in den Fokus.

Führungskräfte können nach § 42 BDSG strafrechtlich belangt werden, wenn personenbezogene Daten unrechtmäßig verarbeitet oder Sicherheitsvorkehrungen fahrlässig unterlassen werden (Wybitul/Klaas, NZWiSt 2021, 216 ff.).

Die Vorschrift stellt nicht auf den Vorsatz, sondern auf den objektiven Pflichtverstoß ab – eine Verschiebung hin zu einer präventiven Unternehmensverantwortung, die strafrechtliche Risiken in die Compliance-Sphäre verlagert.

Damit ist klar: Datenschutzverstöße sind längst nicht mehr nur Ordnungswidrigkeiten, sondern strafbewehrte Pflichtverletzungen.

Unternehmen, die KI-gestützte Systeme einsetzen, stehen damit doppelt im Fokus – einerseits als Verantwortliche im Sinne der DSGVO, andererseits als potenzielle Täter im Sinne des § 42 BDSG oder des § 15 StGB (Fahrlässige Datenverarbeitung).

Praktische Relevanz für Unternehmen und Entwickler

Für Entwickler, Plattformbetreiber und Entscheidungsträger bedeutet das:

Jedes KI-System, das personenbezogene Daten verarbeitet, ist ein juristisches Risikosystem.

Nicht nur technische Fehlfunktionen, sondern auch mangelhafte Schulung, unzureichende Transparenz oder fehlende Auditfähigkeit können zur Haftung führen.

Die rechtliche Verantwortung entsteht also nicht erst bei einem Schaden, sondern bereits bei der fehlenden Kontrolle – ein Paradigmenwechsel im Zusammenspiel von Technik und Recht.

Weiterführend: Was kostet eigentlich eine Datenschutzverletzung? – wie Gerichte Datenschutzverstöße bewerten und welche Summen Unternehmen tatsächlich riskieren.

Die neue Verantwortungsmatrix – Wer haftet bei KI-Fehlern?

Die Frage, wer haftet, wenn eine KI-Entscheidung fehlerhaft oder diskriminierend ist, gehört zu den größten juristischen Herausforderungen der Gegenwart. In der Praxis zeigt sich: Verantwortung ist nicht mehr monolithisch, sondern verteilt. Die neue Verantwortungsmatrix unterscheidet drei zentrale Akteure – Entwickler, Betreiber und Nutzer – die jeweils eigene, klar umrissene Pflichten tragen. Jede dieser Rollen steht an einem anderen Punkt der Kette zwischen Datenerhebung, algorithmischer Verarbeitung und praktischer Anwendung.

Entwickler: Verantwortung im Quellcode

Entwickler legen den rechtlichen Grundstein jedes KI-Systems. Sie bestimmen, mit welchen Daten trainiert, welche Bias-Kontrollen durchgeführt und welche Testumgebungen etabliert werden.

Fehler in diesem Stadium wirken sich unmittelbar auf die Fairness und Zuverlässigkeit späterer Entscheidungen aus.

Die EU-KI-Verordnung (KI-VO) verpflichtet Entwickler zur Dokumentation, Offenlegung und Nachvollziehbarkeitder Trainingsdaten. Dabei müssen insbesondere die Grundsätze der Datenminimierung und Zweckbindung beachtet werden (Golland 2024, EuZW 846 ff.).

Ein unzureichend kuratierter Datensatz kann nicht nur diskriminierende Ergebnisse erzeugen, sondern auch als Verstoß gegen Datenschutzrecht gewertet werden.

Bei fehlerhaften Trainingsdaten oder algorithmischen Mängeln haften Entwickler zivilrechtlich, insbesondere nach den Regeln der Produkthaftung oder bei außervertraglicher Gefährdungshaftung (Rüsing 2025, Jura 843 ff.).

Damit sind sie nicht nur technisch, sondern auch juristisch die erste Verteidigungslinie gegen systemische Fehlentwicklungen.

Weiterführend: Dataset-Governance & Auditfähigkeit: Rechtssicherheit im KI-Training – wie sich Trainingsdaten, Auditpflichten und Nachvollziehbarkeit künftig rechtlich verzahnen.

Betreiber: Überwachungspflicht und Kontrollmechanismen

Betreiber übernehmen die aktive Verantwortung im Betrieb eines KI-Systems.

Ihre Pflicht besteht darin, laufend zu überwachen, zu prüfen und einzugreifen, sobald Fehlentscheidungen oder Sicherheitsrisiken erkennbar sind.

Versäumnisse in dieser Phase führen unmittelbar zu Haftungsrisiken – sowohl nach der DSGVO als auch nach nationalem Datenschutz- und Strafrecht.

Nach Art. 22 DSGVO ist es unzulässig, dass ausschließlich automatisierte Entscheidungen erhebliche Auswirkungen auf Betroffene haben, ohne dass ein Mensch eingebunden ist.

Unternehmen müssen daher sicherstellen, dass jede KI-Entscheidung einem sogenannten „Human in the Loop“-Mechanismus unterliegt (Bronner 2024, jurisPR-ITR 5/2024).

Diese Pflicht schützt nicht nur die Betroffenenrechte, sondern auch die Betreiber selbst vor späterer Beweisnot.

Wer Überwachungspflichten ignoriert oder die technische Kontrolle unzureichend ausgestaltet, riskiert nicht nur Bußgelder, sondern auch Organhaftung nach § 130 OWiG oder strafrechtliche Ermittlungen bei Verstößen gegen § 42 BDSG (Kahl/Rabsahl 2025, CB 50 ff.).

Weiterführend: IT- und Plattformrecht – Plattformhaftung, IT-Sicherheit und Nutzerinhalte – warum Aufsicht, Sicherheit und Haftung im digitalen Ökosystem untrennbar verbunden sind.

Nutzer: Anwendung und Zweckbindung

Auch Nutzer – ob Unternehmen oder Privatpersonen – tragen Verantwortung.

Sie müssen sicherstellen, dass KI-Systeme gemäß ihrer Bestimmung eingesetzt und die Vorgaben der Entwickler und Betreiber eingehalten werden.

Eine zweckwidrige Nutzung kann nicht nur zivilrechtliche Schadensersatzpflichten auslösen, sondern bei bewusster Manipulation oder Missbrauch auch strafrechtlich relevant sein.

In der Praxis entstehen Haftungsfälle häufig dadurch, dass Systeme außerhalb ihrer Zulassung oder Trainingsbasis verwendet werden.

Wer etwa eine interne Analyse-KI für externe Kundendaten nutzt, verstößt sowohl gegen Zweckbindungsgrundsätze als auch gegen die Compliance-Pflichten des Unternehmens (Beckhove 2025, AiB Nr. 4, 13 ff.).

Verbindung zu Art. 22 DSGVO – Menschliche Kontrolle als Schutzmechanismus

Art. 22 DSGVO markiert den zentralen juristischen Grenzstein automatisierter Entscheidungsverfahren.

Er verlangt Transparenz, Nachvollziehbarkeit und die Möglichkeit einer menschlichen Intervention.

Unternehmen müssen:

- offengelegen, wie ihre Systeme Entscheidungen treffen,

- sicherstellen, dass menschliche Überprüfung jederzeit möglich ist,

- und Betroffenen Widerspruchs- und Auskunftsrechte gewähren.

Der EuGH hat mit Urteil vom 7. Dezember 2023 (C-634/21) bestätigt, dass automatisiertes Scoring ohne menschliche Kontrolle unzulässig ist.

Damit wird Art. 22 DSGVO praktisch zum Fundament jeder künftigen KI-Compliance.

Beispielhafte Risikoanalyse aus Unternehmenssicht

Eine unternehmensinterne Risikoanalyse sollte heute technische, rechtliche und organisatorische Komponenten gleichermaßen berücksichtigen:

- Technische Risiken: Unzureichende Trainingsdaten, Bias oder fehlerhafte Modelle führen zu Fehlentscheidungen und Diskriminierung.

- Rechtliche Risiken: Verstöße gegen Datenschutz- oder KI-Vorgaben können Bußgelder, Haftungsansprüche und Reputationsschäden auslösen.

- Organisatorische Risiken: Fehlende Kontrollstrukturen oder unklare Verantwortlichkeiten erschweren Nachweis und Verteidigung.

- Maßnahmen: Implementierung klarer Prüfprozesse, Mitarbeiterschulung, Datenschutz-Folgenabschätzung und regelmäßige Audits nach BfDI-Prüfkatalog (Weiss 2025, DSB 171 ff.).

So entsteht aus technischer Innovation rechtliche Sicherheit – und aus Verantwortung Vertrauen.

Datenschutzrechtliche Verknüpfung mit dem Strafrecht

Die Verbindung zwischen Datenschutzrecht und Strafrecht ist enger, als viele Unternehmen annehmen. Während die DSGVO vor allem auf zivilrechtliche Haftung und Schadensersatz zielt, greifen im Hintergrund strafrechtliche Normen, sobald Datenschutzverstöße vorsätzlich oder grob fahrlässig begangen werden – oder technische Versäumnisse sicherheitsrelevante Folgen haben.

Gerade im Kontext von KI-Systemen, die personenbezogene Daten verarbeiten, wird diese Verknüpfung zunehmend relevant. Denn jede automatisierte Entscheidung birgt auch ein strafrechtliches Risiko: Manipulation, Unterlassung oder unbefugte Verarbeitung können Ermittlungen auslösen.

§ 42 BDSG – Strafbarkeit von Datenschutzverstößen

§ 42 BDSG bildet das strafrechtliche Fundament des deutschen Datenschutzrechts.

Er erfasst Fälle, in denen personenbezogene Daten unbefugt verarbeitet, verändert oder an Dritte weitergegebenwerden.

Besonders risikobehaftet sind Konstellationen, in denen Daten gewerbsmäßig oder wiederholt genutzt werden – etwa für Profiling, Scoring oder algorithmische Auswertungen ohne Einwilligung.

In der Praxis sind hiervon regelmäßig Geschäftsleitungen und Compliance-Verantwortliche betroffen, deren Garantenstellung sie zu einer aktiven Überwachung verpflichtet (Wybitul/Klaas, NZWiSt 2021, 216 ff.).

Unternehmen als juristische Personen sind zwar nicht unmittelbar strafbar, können aber über Verbandsgeldbußen (§ 30 OWiG) und Einziehung nach § 73b StGB finanziell empfindlich getroffen werden.

§ 42 BDSG ist somit kein Randtatbestand, sondern der strafrechtliche Hebel, mit dem Datenschutzverstöße in Unternehmensrealität übersetzt werden – gerade dort, wo KI-Systeme Daten ohne ausreichende Kontrolle verarbeiten.

§ 303a StGB – Datenveränderung als Straftatbestand

Auch § 303a StGB („Datenveränderung“) gewinnt im digitalen Umfeld neue Bedeutung.

Er erfasst nicht nur vorsätzliche Manipulation, sondern auch technische Fehler mit strafrechtlicher Relevanz, etwa durch unsachgemäße Software-Updates, fehlerhafte Speicherprozesse oder unbefugte Eingriffe in Trainingsdaten.

Was früher Sabotagehandlungen betraf, wird heute zum Risiko für jeden automatisierten Datenprozess (Peters, Computerkriminalität, 2025).

Damit können bereits technische Fehlkonfigurationen – etwa mangelnde Zugriffsbeschränkungen oder ungesicherte Schnittstellen – den Anfangsverdacht begründen, der zu einer strafrechtlichen Untersuchung führt.

Technische Fehler und Ermittlungsanlässe

Fehlende oder unzureichende technische und organisatorische Maßnahmen (TOMs) im Sinne des Art. 32 DSGVO führen nicht nur zu Bußgeldern, sondern können auch strafrechtlich relevant sein.

Wenn Sicherheitslücken bekannt, aber nicht behoben werden, kann der Vorwurf einer pflichtwidrigen Unterlassungentstehen.

Die Rechtsprechung des Schleswig-Holsteinischen OLG (Urt. v. 18.12.2024 – 12 U 9/24) zeigt, dass selbst unsichere E-Mail-Versandstrukturen als Organisationsverschulden bewertet werden können – mit zivil- und strafrechtlichen Folgen.

Gerade bei KI-Systemen, die kontinuierlich Daten verarbeiten und Entscheidungen generieren, bedeutet dies: Technische Nachlässigkeit wird juristisch als Fahrlässigkeit gewertet.

KI-Systeme als Beweismittel – Grenzen der Verwertbarkeit

Zunehmend werden KI-Systeme selbst zu Beweismitteln in Straf- und Zivilverfahren.

Doch wenn die zugrunde liegenden Daten unrechtmäßig erhoben wurden, droht ein Beweisverwertungsverbot.

Nach der Rechtsprechung (Däubler, jurisPR-ArbR 37/2024 Anm. 1) gilt: Informationen, die unter Verstoß gegen die DSGVO oder ohne Transparenzpflichten erlangt wurden, dürfen grundsätzlich nicht verwertet werden.

Gerichte müssen daher künftig prüfen,

- ob die Datenerhebung verhältnismäßig war,

- ob Alternativen (z. B. Bußgeld oder Schadensersatz) ausgereicht hätten,

- und ob die Nutzung im Strafverfahren mit dem Recht auf informationelle Selbstbestimmung vereinbar ist.

Für Unternehmen bedeutet dies, dass jede unrechtmäßige Datenverarbeitung – auch unbeabsichtigt – nicht nur Bußgelder, sondern Verlust von Beweismitteln in Verfahren zur Folge haben kann.

Parallelen zu Art. 82 DSGVO – Schadensersatz und Strafbarkeit

Art. 82 DSGVO eröffnet Betroffenen Schadensersatzansprüche für materielle und immaterielle Schäden.

Er ergänzt die strafrechtliche Verantwortlichkeit durch eine zivilrechtliche Kompensationsebene:

Jeder Datenschutzverstoß kann zugleich einen zivilrechtlichen Anspruch und eine strafrechtliche Pflichtverletzung auslösen.

Unternehmen haften nicht nur für eigenes Verschulden, sondern auch für Versäumnisse ihrer Auftragsverarbeiter (Pohle/Adelberg, ZD 2024, 312 ff.).

Die Beweislast liegt beim Betroffenen – doch Verantwortliche können sich nur dann entlasten, wenn sie umfassende Compliance-Nachweise, Risikoanalysen und TOMs vorlegen können.

Gerade in Kombination mit KI-Systemen wird dieser Nachweis immer schwieriger, weil sich Entscheidungen oft nicht vollständig rekonstruieren lassen.

Weiterführend: Was kostet eigentlich eine Datenschutzverletzung? – wie Gerichte den Kontrollverlust über personenbezogene Daten heute als Schaden werten.

Fazit

Die Schnittstelle zwischen Datenschutzrecht und Strafrecht ist kein theoretisches Konstrukt, sondern gelebte Unternehmensrealität.

Verstöße gegen Datenschutzpflichten können heute dreifach wirken: als zivilrechtlicher Schadensersatz, als behördliches Bußgeld und als strafrechtliche Verantwortung.

Wer KI-Systeme betreibt oder trainiert, muss daher nicht nur technische Sicherheit, sondern auch juristische Beweisführung und Compliance-Strukturen gewährleisten.

Die Zukunft des Datenschutzrechts ist damit zugleich die Zukunft des Unternehmensstrafrechts

Der EU AI Act als Zündfunke für neue Verfahren

Mit dem Inkrafttreten des EU AI Act beginnt eine neue Phase der Regulierung: Künstliche Intelligenz wird erstmals als rechtliches Risikosystem definiert.

Besonders im Bereich der Hochrisiko-KI-Systeme zeigt sich, dass technische Pflichten künftig straf- und haftungsrechtliche Relevanz entfalten können.

Was bisher als Compliance-Thema galt, wird damit zum potentiellen Ermittlungsgegenstand – insbesondere dort, wo Unternehmen Kontroll-, Dokumentations- oder Überwachungspflichten vernachlässigen.

Überblick über Hochrisiko-KI-Systeme

Nach Art. 6 Abs. 2 i. V. m. Anhang III AI Act gelten als Hochrisiko-KI-Systeme insbesondere solche, die in kritischen Bereichen wie Infrastruktur, Bildung, Beschäftigung, Gesundheitswesen, Strafverfolgung oder Justiz eingesetzt werden.

Diese Systeme sind durch ihre gesellschaftliche und sicherheitsrelevante Wirkung besonders reguliert. Sie dürfen nur betrieben werden, wenn sie Risikomanagement, Dokumentationspflichten und technische Nachvollziehbarkeitgewährleisten (Figatowski 2024, PStR 154 ff.; Bronner 2023, jurisPR-ITR 15/2023 Anm. 2).

Der Gesetzgeber verfolgt damit einen risikobasierten Ansatz:

Je größer das Schadenspotenzial eines Systems, desto strenger die Anforderungen.

Für Unternehmen bedeutet das, dass insbesondere Systeme mit automatisierter Entscheidungsfindung – etwa im Personalwesen, bei Kreditscoring oder Compliance-Screenings – unter das Hochrisiko-Regime fallen können.

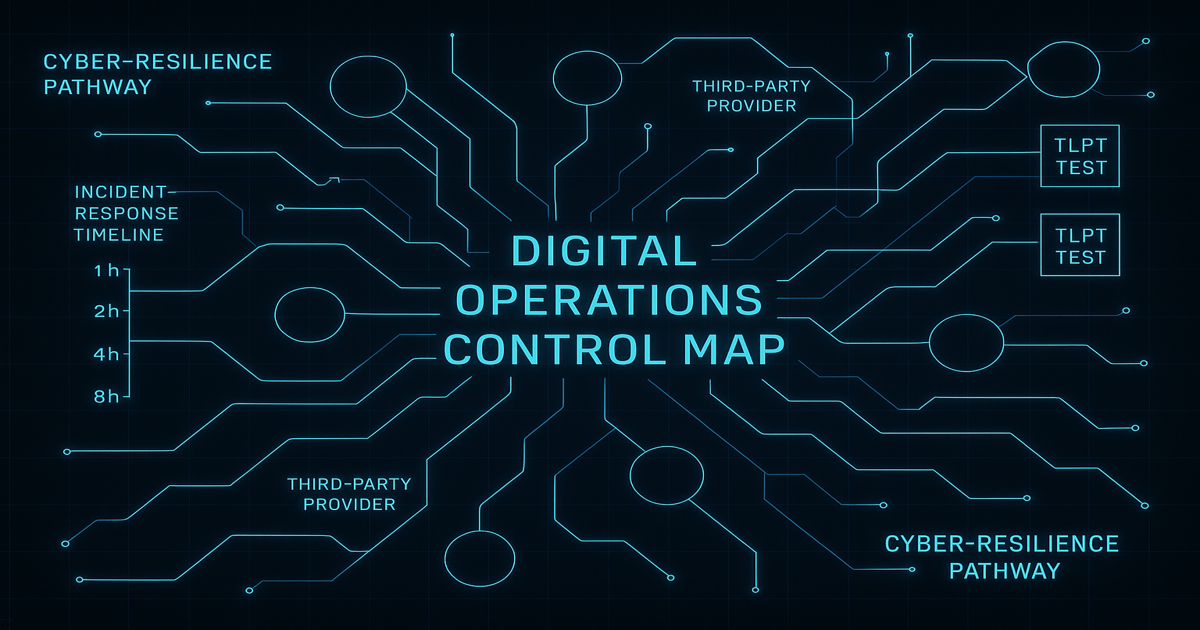

Pflichten: Dokumentation, Risikomanagement, Auditability

Die Pflichten des AI Act sind umfassend und technisch anspruchsvoll. Sie lassen sich auf drei Kernbereiche verdichten:

1. Dokumentation (Art. 11 AI Act)

Unternehmen müssen eine technische Dokumentation führen, die Aufbau, Funktionsweise, Trainingsdaten, Parameter und Änderungen der KI nachvollziehbar festhält.

Die Dokumentation ist laufend zu aktualisieren – eine statische Beschreibung genügt nicht.

Fehler oder Lücken können bei behördlichen Audits als Compliance-Verstoß gewertet werden (Marx 2021, jurisPR-ITR 19/2021 Anm. 2).

2. Risikomanagement (Art. 9 AI Act)

Anbieter und Betreiber müssen ein kontinuierliches Risikomanagementsystem etablieren, das Gefahren erkennt, bewertet und minimiert.

Dies umfasst technische Prüfungen, Bias-Analysen und Kontrollmechanismen zur Fehlererkennung.

Die Pflicht besteht dauerhaft, nicht nur vor Markteinführung.

3. Auditability (Art. 12 AI Act)

Hochrisiko-Systeme müssen eine Protokollierungs- und Nachvollziehbarkeitsfunktion besitzen.

Alle automatisierten Entscheidungen müssen im Nachhinein überprüfbar sein.

Damit wird die technische Architektur selbst zum Beweismittel – ein entscheidender Schritt für forensische Nachvollziehbarkeit und juristische Haftungsprüfung.

Verbindung zur Strafbarkeit durch Unterlassen (§ 13 StGB)

Diese Pflichten entfalten Wirkung über das klassische Verwaltungsrecht hinaus.

Wer sie ignoriert oder unzureichend umsetzt, kann sich unter Umständen nach § 13 StGB strafbar machen – wegen Unterlassens trotz Garantenpflicht.

Insbesondere Geschäftsleiter, Vorstände und Compliance-Beauftragte stehen hierbei im Fokus:

Sie sind Garanten für die Einhaltung rechtlicher Pflichten innerhalb ihres Verantwortungsbereichs (Wybitul/Klaas 2021, NZWiSt 216 ff.).

Ein typisches Risiko entsteht, wenn Compliance-Strukturen zwar formal bestehen, aber keine effektive Kontrolle über KI-Systeme gewährleisten.

In solchen Fällen kann der Vorwurf einer pflichtwidrigen Untätigkeit entstehen – analog zu den Grundsätzen der Organisations- und Überwachungshaftung im Unternehmensstrafrecht (Peters, Computerkriminalität, 2025).

Damit verlagert sich das Haftungsrisiko von der Maschine zurück auf den Menschen, der sie zulässt oder nicht ausreichend überwacht.

Bedeutung für Unternehmen: Haftung, Compliance, Geschäftsleiterpflichten

Die rechtlichen Konsequenzen des AI Act reichen weit über Bußgelder hinaus.

Sie betreffen drei Ebenen der Unternehmensorganisation:

1. Haftung

Unternehmen und Geschäftsleiter haften, wenn sie ihre Pflichten aus dem AI Act verletzen.

Neben zivilrechtlichen Ansprüchen kommen straf- und ordnungswidrigkeitenrechtliche Sanktionen in Betracht (Rüsing 2025, Jura 843 ff.).

Fehlende Dokumentation oder unzureichende Kontrolle kann als grobe Fahrlässigkeit oder Organisationsverschulden gewertet werden.

2. Compliance

Die Umsetzung des AI Act verlangt integrierte Compliance-Management-Systeme.

Diese müssen sowohl technische als auch organisatorische Komponenten umfassen: Risikoanalysen, interne Meldewege, Auditverfahren und Verantwortlichkeitszuordnungen (Heißner/Schaffer 2018, CCZ 147 ff.).

Compliance wird damit zur First Line of Defense gegen straf- und haftungsrechtliche Verfahren.

3. Geschäftsleiterpflichten

Geschäftsleiter sind verpflichtet, die Umsetzung der AI-Act-Vorgaben persönlich zu überwachen.

Eine Vernachlässigung kann zu persönlicher Haftung führen – ähnlich wie bei ESG- oder Datenschutzverstößen (Erling/Willms 2025, ESGZ Nr. 8, 34 ff.).

Damit entsteht eine neue Form der Managerhaftung im KI-Zeitalter, die sowohl die technische als auch die juristische Verantwortung integriert.

Fazit

Der EU AI Act ist weit mehr als ein Compliance-Rahmen – er ist ein Auslöser für neue Ermittlungs- und Haftungsverfahren.

Er zwingt Unternehmen, KI-Systeme nicht nur technisch zu verstehen, sondern juristisch abzusichern.

Wer Dokumentations-, Risiko- oder Überwachungspflichten vernachlässigt, riskiert nicht nur Bußgelder, sondern auch strafrechtliche Vorwürfe wegen Unterlassens.

Die Verbindung von Technikrecht, Strafrecht und Unternehmensverantwortung markiert damit den Beginn einer neuen Ära der KI-Haftung in Europa.

Forensische Perspektive – Von Datenfehlern zu Haftungsfällen

KI-Systeme produzieren täglich unzählige Datenspuren – Protokolle, Trainingsdaten, Nutzerinteraktionen, Logfiles.

Was in der Entwicklung als technische Notwendigkeit gedacht war, wird im Streitfall zum Beweismittel erster Ordnung.

Genau hier zeigt sich die forensische Relevanz der neuen Haftungsstruktur:

Technische Fehler, unzureichende Löschprozesse oder unkontrollierte Datenweitergaben können nicht nur zivilrechtliche Schadensersatzansprüche, sondern auch strafrechtliche Verfahren nach sich ziehen.

Von der Datenabweichung zum Ermittlungsverfahren

In der Praxis beginnt ein Verfahren selten mit dem Vorwurf „Verstoß gegen den AI Act“.

Der Ausgangspunkt ist meist ein konkreter Datenschutzverstoß, ein fehlerhaftes Scoring oder ein nicht erklärbares Systemverhalten.

Sobald ein solcher Vorfall bekannt wird – etwa durch eine Datenschutzaufsicht, einen Whistleblower oder eine betroffene Person –, prüfen Ermittlungsbehörden, ob Pflichten aus dem AI Act, der DSGVO oder dem BDSG verletzt wurden.

Entscheidend ist dabei, ob der Vorfall vermeidbar gewesen wäre.

Wenn interne Kontrollmechanismen existierten, aber nicht angewandt wurden, steht schnell der Verdacht eines Organisationsverschuldens oder einer fahrlässigen Datenverarbeitung (§ 15 StGB) im Raum.

Unternehmen müssen daher nicht nur nachweisen, was geschehen ist, sondern auch, wie sie versucht haben, es zu verhindern.

Beweisarchitektur und Datenforensik

Die juristische Aufarbeitung von KI-Vorfällen erfordert ein neues Verständnis von Beweisarchitektur.

Wo früher Zeugen und Dokumente dominierten, entscheiden heute Datenprotokolle, Trainingshistorien und Audit-Trails über Schuld oder Entlastung.

Nur wer diese Daten vollständig, strukturiert und nachvollziehbar sichern kann, behält im Verfahren die Kontrolle über den Sachverhalt.

Forensisch entscheidend ist:

- Audit-Trails müssen zeitlich, technisch und personell zuordenbar sein.

- Trainingsdaten dürfen nicht nachträglich manipuliert oder gelöscht werden.

- Systemversionen sind zu archivieren, um den technischen Stand zum Tatzeitpunkt rekonstruieren zu können.

Das gilt gleichermaßen für interne Untersuchungen wie für behördliche Verfahren.

Gerade in KI-gestützten Compliance-Systemen können Fehlalarme, Bias oder algorithmische Fehlentscheidungen als Beweisgrundlage herangezogen werden – auch gegen das Unternehmen selbst.

Die Grenze zwischen Beweismittel und Tatwerkzeug verschwimmt.

Verteidigungsstrategien im KI-Kontext

Die Verteidigung in Verfahren rund um KI-Fehler unterscheidet sich fundamental von klassischen Strafsachen.

Im Mittelpunkt steht nicht die Tat als Handlung, sondern das Systemverhalten – und damit die Frage, ob der Mensch, der die Verantwortung trug, die richtigen Vorkehrungen getroffen hat.

Eine effektive Verteidigung muss deshalb:

- die technische Nachvollziehbarkeit der KI-Entscheidungen sichern,

- organisatorische Pflichten (z. B. nach Art. 9–12 AI Act, Art. 32 DSGVO) dokumentieren,

- und frühzeitig forensische Gutachten einholen, um die Plausibilität der Ergebnisse zu prüfen.

Je besser die interne Dokumentation aufgebaut ist, desto stärker die Beweislage für die Verteidigung.

Ein KI-System kann somit nicht nur Risiko, sondern auch Entlastungsinstrument sein – sofern die rechtlichen und technischen Schnittstellen sauber dokumentiert wurden.

Praxisfall: Wenn Daten zur Strafsache werden

Ein klassisches Szenario:

Ein Unternehmen nutzt eine KI-basierte Bewerberanalyse.

Das System sortiert Bewerber automatisch aus – aufgrund unzureichend trainierter Datensätze fällt dabei eine Diskriminierung auf.

Ein Bewerber klagt auf Schadensersatz nach Art. 82 DSGVO; parallel prüft die Staatsanwaltschaft, ob eine fahrlässige Verletzung der Aufsichtspflicht (§ 13 StGB) vorliegt.

Die Verteidigung hängt dann davon ab, ob die Geschäftsleitung ein dokumentiertes Kontrollsystem nachweisen kann.

Fehlt dieser Nachweis, kann aus einem Compliance-Verstoß schnell ein strafrechtlich relevanter Organisationsfehler werden.

Dieses Beispiel zeigt: KI-Fehler sind keine hypothetischen Risiken, sondern reale Haftungsquellen.

Fazit und Handlungsempfehlung

Die forensische Perspektive macht deutlich: KI-Haftung ist kein Zukunftsthema mehr, sondern gelebte Gegenwart.

Unternehmen müssen ihre Systeme, Prozesse und Verantwortlichkeiten so dokumentieren, dass sie in Ermittlungsverfahren standhalten.

Der Schlüssel liegt in der proaktiven Compliance-Struktur, die juristische, technische und organisatorische Kontrolle miteinander verbindet.

🔍 Sie möchten wissen, ob Ihr Unternehmen oder Ihre KI-Systeme haftungsrelevant sind – oder wie Sie sich gegen drohende Verfahren absichern können?

Besuchen Sie hortmannlaw.com/contact oder vereinbaren Sie direkt ein vertrauliches Beratungsgespräch.

Rechtsanwalt Max Nikolas Mischa Hortmann berät Sie zu Haftungsprävention, Compliance-Strukturen und Verteidigungsstrategien im KI- und Datenschutzrecht.

Weiterführende Inhalte

Digitale Risiken verstehen – diese drei Leitartikel zeigen, wie tief KI, Marketing und Betrug heute ineinandergreifen und welche Rechte Betroffene haben.

KI-Entscheidungssysteme in Apps – Haftung, Transparenz und Pflichten für Startups

www.hortmannlaw.com/articles/anwalt-ki-apps-startup-haftung

Kurzbeschreibung: Dieser Artikel erklärt, wann KI-Apps rechtlich reguliert sind, welche Transparenz- und Kontrollpflichten bestehen und wie Startups ihre KI-Systeme rechtskonform entwickeln und überwachen.

KI-Marketing & KI-Content – Risiken für Agenturen und Startups

www.hortmannlaw.com/articles/anwalt-ki-marketing-content-haftung

Kurzbeschreibung: Ob KI-generierte Texte, Bilder oder automatisierte Kampagnen – dieser Beitrag zeigt die wichtigsten urheberrechtlichen, datenschutzrechtlichen und lauterkeitsrechtlichen Risiken für Agenturen und kreative Unternehmen.

KI-Betrug, Love Scam & Krypto-Scams – moderne Täuschungsmethoden und Opferrechte

www.hortmannlaw.com/articles/anwalt-ki-betrug-love-scam-krypto-beweise

Kurzbeschreibung: Dieser Leitfaden beleuchtet, wie KI-Chatbots, Deepfakes und Wallet-Routings Betrugsmodelle verstärken, und zeigt, welche Ansprüche Opfer gegen Plattformen, Exchanges und Zahlungsdienste haben.

Künstliche Intelligenz (KI) und Digitales Recht

Die rasante Entwicklung von KI-Systemen stellt Recht und Gesellschaft vor neue Herausforderungen. Ob Produkthaftung, Datenschutz, Urheberrecht oder regulatorische Anforderungen wie der AI Act – wir beraten Unternehmen und Entwickler bei der rechtssicheren Gestaltung und dem verantwortungsvollen Einsatz von KI-Technologien.

- A bis Z für Digital Creator: Die wichtigsten Red Flags und wie du sie vermeidest (Teil 2)

https://www.hortmannlaw.com/articles/vertragsfallen-fur-musiker - AI Act Zertifizierungspflicht

https://www.hortmannlaw.com/articles/ai-act-zertifizierungspflicht - Abmahnwelle durch KI-generierte Inhalte

https://www.hortmannlaw.com/articles/abmahnwelle-durch-ki-generierte-inhalte - Coldmailing legal absichern – So bleiben Kaltakquise-E-Mails rechtskonform

https://www.hortmannlaw.com/articles/coldmailing-legal-absichern - Dataset-Governance & Auditfähigkeit: Rechtssicherheit im KI-Training

https://www.hortmannlaw.com/articles/dataset-governance-auditfahigkeit-rechtssicherheit-im-ki-training - Exklusivitätsklauseln in Modelverträgen

https://www.hortmannlaw.com/articles/exklusivitatsklauseln-in-modelvertragen - Fehlfunktionen von KI-Systemen als Haftungsfalle

https://www.hortmannlaw.com/articles/fehlfunktionen-von-ki-systemen-als-haftungsfalle - Finanzierung & Kapitalbeschaffung für KI-Start-ups

https://www.hortmannlaw.com/articles/finanzierung-kapitalbeschaffung-ki-start-ups - Gesellschaftsformen und Gründung von KI-Start-ups: Ein Leitfaden für Gründer

https://www.hortmannlaw.com/articles/grundung-ki-startup - Haftung und Compliance im KI-Bereich

https://www.hortmannlaw.com/articles/haftung-und-compliance-im-kl-bereich - Internationale Expansion von KI-Start-ups: Rechtliche Fallstricke und Chancen

https://www.hortmannlaw.com/articles/internationale-expansion-ki - KI Musikrecht in der Praxis

https://www.hortmannlaw.com/articles/ki-musikrecht-praxis - KI und Recht - Trainingsdaten, Produkthaftung und Einsatz im Unternehmen

https://www.hortmannlaw.com/articles/ki-und-recht-trainingsdaten-produkthaftung-und-einsatz-im-unternehmen - KI-Spezial – Teil II – Fragmentierte Kontrolle – juristische Resonanzarchitektur gegen maschinelle Lesbarkeit

https://www.hortmannlaw.com/articles/ki-spezial-teil-ii-internationale-erbengemeinschaften-typische-nachlassprobleme-bei-grenzuberschreitender-abwicklung - KI-Vertragspflichten in Agenturen – Wer haftet für automatisierte Fehler?

https://www.hortmannlaw.com/articles/ki-vertragspflichten-in-agenturen - Risikoklassen im AI Act – Überblick und Bedeutung für Unternehmen

https://www.hortmannlaw.com/articles/risikoklassen-im-ai-act-uberblick-und-bedeutung-fur-unternehmen - Schadensersatz & Unterlassung bei Online-Rechtsverletzungen – Zivilrechtliche Optionen neben der Strafanzeige

https://www.hortmannlaw.com/articles/schadensersatz-und-unterlassung-online-rechtsverletzungen - Urheberrecht & KI-Training: Schranken, Lizenzen und Opt-out

https://www.hortmannlaw.com/articles/urheberrecht-ki-training-schranken-lizenzen-und-opt-out

Das könnte Sie auch interessieren

Entdecken Sie weitere Beiträge zu aktuellen Themen rund um Digitalrecht, Cybercrime, Datenschutz, KI und Steuerrecht. Unsere verwandten Artikel geben Ihnen zusätzliche Einblicke und vertiefende Analysen.

.jpg)

DORA für Krypto 2025: Anwalt erklärt Token-, CASP- & Outsourcing-Pflichten

DORA verlangt von Krypto-Anbietern einheitliche Incident-Meldungen, Red-Team-Tests, IKT-Risikomanagement und strenge Cloud-Governance. Der Beitrag zeigt, welche Pflichten für Token-Emittenten, CASPs und Plattformbetreiber 2025 verbindlich werden.

.jpg)

Organhaftung 2025: Anwalt erklärt MiCA-, KMAG- & DORA-Pflichten für Krypto und Token

MiCA, KMAG und DORA schaffen erstmals eine umfassende persönliche Haftung für Geschäftsleiter im Krypto-Sektor. Fehler bei Whitepaper, Governance oder IT-Sicherheit führen zu individuellen Sanktionen, Bußgeldern oder Berufsverboten. Der Beitrag zeigt Pflichten und Schutzstrategien.

.jpg)

ART-Token 2025: Anwalt erklärt Governance, Preisstabilität & Krypto-Haftung

Asset-referenced Tokens erfordern robuste Governance, Preisstabilitätsmechanismen und Oracle-Sicherheit. MiCA macht Emittenten persönlich verantwortlich für Stabilität, Updates und Markttransparenz. Der Beitrag zeigt Risiken, Haftung und Compliance-Strukturen.

Suchen Sie dringend diskrete, juristische Unterstüzung?

Wir helfen Ihnen gerne persönlich weiter – schildern Sie uns Ihr Anliegen und wir finden gemeinsam eine Lösung.