Fehlfunktionen von KI-Systemen als Haftungsfalle

Juristische Expertise

- Cybercrime & Krypto-Betrug

- AI & Zukunftsrecht

- Steuerrecht & Steuerstrafrecht

- Gesellschaftsrecht, Immobilienrecht & Zivilrecht

- Datenschutz & Digitalrecht

Fehlfunktionen von KI-Systemen als Haftungsfalle

KI-Systeme und Produkthaftung: Wer haftet bei Fehlern? Versagt eine KI, droht zivil- und strafrechtliche Haftung. Wann Entwickler, Betreiber oder Hersteller zahlen – und wie man Risiken beweisfest absichert.Ob autonomes Fahren, medizinische Diagnosesoftware oder Chatbots – wenn selbstlernende Systeme Fehler machen, stellt sich die Frage nach der Haftung. Dieser Beitrag beleuchtet, welche zivil- und strafrechtlichen Folgen Fehlentscheidungen von KI-Systemen haben können und warum Unternehmen neue Wege finden müssen, diese Risiken mit Dokumentation und Compliance zu beherrschen.

Ausgangslage – Wenn Algorithmen Fehler machen

Künstliche Intelligenz kann heute in vielen Bereichen autonom Entscheidungen treffen – vom selbstfahrenden Auto, das in Sekundenbruchteilen reagieren muss, bis zum Algorithmus, der Kreditwürdigkeitsprüfungen vornimmt. Doch was passiert, wenn die KI falsch entscheidet? Denkbar sind z. B. Unfälle durch ein autonomes Fahrzeug, gravierende Fehlempfehlungen einer medizinischen KI oder umfangreiche Systemausfälle in der Infrastruktur.

Solche Vorfälle werfen sofort die Haftungsfrage auf. Anders als bei einem menschlichen Mitarbeiter, der einen Fehler macht, ist bei einer KI oft unklar, wer im Haftungskreislauf verantwortlich ist. Mögliche Akteure sind der Herstellerder KI-Software bzw. Hardware, der Betreiber (das Unternehmen, das die KI einsetzt), evtl. ein Integrator oder Dienstleister, der die KI implementiert hat, sowie im weiteren Sinne sogar der Nutzer, der die KI angewendet hat. Die Herausforderung besteht darin, die Verantwortlichkeit zuzuordnen, wenn die KI ohne unmittelbare menschliche Steuerung agiert. Hier zeigt sich ein Dilemma: Je autonomer ein System, desto weniger passt es in die klassischen Haftungskategorien, die immer von einem menschlichen Fehlverhalten oder Produktfehler ausgehen.

Rechtsrahmen – Produkthaftungsgesetz & EU-KI-Verordnung

Der Gesetzgeber – national wie europäisch – bemüht sich, auf diese neuen Herausforderungen zu reagieren. Zwei Regelungsbereiche sind besonders relevant:

- Produkthaftung (ProdHaftG): Nach geltendem Produkthaftungsgesetz können Hersteller für fehlerhafte Produkte haften, ohne dass ein Verschulden nachgewiesen werden muss (Gefährdungshaftung). Hier stellt sich die Frage, ob Software oder KI-Systeme als „Produkt“ im Sinne des Gesetzes gelten. Die Tendenz geht dahin, diese Frage zu bejahen – insbesondere wenn die KI in physischen Geräten verbaut ist (z. B. im Auto) oder als separat in Verkehr gebrachte Software. Bei Hochrisiko-KI-Systemen (etwa in der Medizin oder Verkehr) könnte es zu einer Beweislastumkehr kommen: Das heißt, im Schadenfall müsste der Hersteller beweisen, dass sein Produkt nichtfehlerhaft war, anstatt der Geschädigte das Vorliegen eines Fehlers beweisen muss. Dieses Prinzip wird in aktuellen Entwürfen zur EU-Produkthaftungsreform und der geplanten EU-KI-Verordnung (AI Act) diskutiert.

- Gefährdungs- vs. Verschuldenshaftung: Neben der Produkthaftung (die eine Gefährdungshaftung darstellt) gibt es klassische Verschuldenshaftung nach BGB (§§ 823 ff.), die ein Verschulden voraussetzt. Bei KI-Fehlfunktionen können beide Haftungsarten ineinandergreifen. Beispiel: Ein Betreiber könnte verschuldenshaftend haften, weil er seine Aufsichtspflichten verletzt hat (etwa keine Notbremse installiert), während der Hersteller gleichzeitig aus Produkthaftung haftet, weil das System aufgrund eines Fehlers unsicher war. Das Zusammenspiel dieser Haftungsregime wird von Juristen und Gerichten noch auszuloten sein. Klar ist aber: Sobald die KI im konkreten Einsatz als Produkt oder Dienst versagt, müssen die bestehenden Gesetze ausgelegt oder angepasst werden, um angemessenen Rechtsschutz für Geschädigte sicherzustellen.

Zivilrechtliche und strafrechtliche Folgen

Bei einer KI-Fehlfunktion kommen unterschiedliche Konsequenzen zum Tragen:

- Zivilrechtliche Haftung: Zunächst stehen zivilrechtliche Ansprüche der Geschädigten im Raum. Wurde jemand verletzt oder sein Eigentum beschädigt (z. B. Verkehrsunfall durch KI-Auto, falsche medizinische Entscheidung mit Gesundheitsschaden), kann er Schadensersatz und Schmerzensgeld verlangen. Hier können Hersteller, Betreiber und evtl. weitere Parteien (Integrator, Wartungsdienst) in Anspruch genommen werden. Oft wird geprüft, ob sie ihre Verkehrssicherungspflichten erfüllt haben – also ob sie alle zumutbaren Maßnahmen ergriffen haben, um Schäden zu vermeiden. Interessant ist auch der Regress untereinander: Wenn z. B. der Betreiber dem Geschädigten zahlt, wird er versuchen, sich dieses Geld vom Hersteller zurückzuholen, falls der Fehler auf einem Produktmangel beruhte. Verträge zwischen diesen Parteien (Hersteller <-> Betreiber) enthalten daher idealerweise Haftungsregeln für solche Fälle.

- Strafrechtliche Verantwortung: Tritt ein Schaden ein, rückt auch das Strafrecht in den Fokus – allerdings stets bezogen auf handelnde Menschen. Eine KI selbst kann nicht angeklagt werden, aber Verantwortliche können z. B. wegen fahrlässiger Tötung oder Körperverletzung belangt werden, wenn sie Sicherheitsregeln missachtet haben. Denkbar ist etwa, dass Entwickler oder Verantwortliche in Unternehmen wegen fahrlässiger Handlung verurteilt werden, wenn sie wissentlich ein unausgereiftes System auf die Menschheit losgelassen haben. Auch Organisationsverschulden kann strafrechtlich relevant sein: Wenn in einem Unternehmen Strukturen so schlecht waren, dass es geradezu zu dem Unfall kommen musste, können Führungskräfte zur Verantwortung gezogen werden. In Deutschland kommt noch das Verbandsanktionengesetz (so es in Kraft tritt) ins Spiel, um Unternehmen selbst bei solchen Vorfällen zu sanktionieren.

- Versicherungsschutz: Angesichts dieser Risiken spielt die Versicherungsbranche eine wichtige Rolle. Unternehmen sollten prüfen, ob ihre Betriebshaftpflichtversicherung oder spezielle Cyber-Versicherungen solche KI-Schäden abdecken. Für autonome Fahrzeuge gibt es bereits Pflichtversicherungen. Zukünftig könnten Pflichtversicherungen auch für andere KI-Systeme kommen, damit Geschädigte auf jeden Fall entschädigt werden (ähnlich der Logik der Kfz-Haftpflicht).

Prävention – Risikomanagement und Nachweis

Um der Haftungsfalle „KI-Fehlfunktion“ vorzubeugen, müssen Unternehmen ein strenges Risikomanagement betreiben:

- Dokumentation und Audits: Von der Entwicklungsphase bis zum laufenden Betrieb sollte jede Entscheidung und Änderung am KI-System dokumentiert werden. Dazu gehören z. B. die Trainingsdaten, Modellversionen, Testläufe und Ergebnisse von Qualitätssicherungen. Diese Dokumentation ermöglicht es im Nachhinein, den Hergang eines Fehlers nachzuvollziehen – was vor Gericht entscheidend sein kann. Regelmäßige Audits (intern oder extern) helfen, Schwachstellen früh zu erkennen.

- Update- und Wartungspflichten: KI-Systeme benötigen kontinuierliche Pflege. Neue Erkenntnisse oder Vorfälle sollten umgehend in Updates einfließen (z. B. ein autonomes Fahrzeug, das einen Beinahe-Unfall hatte, erhält ein Software-Update, das diesen speziellen Fall künftig berücksichtigt). Verträge zwischen Herstellern und Betreibern sollten klare Regelungen enthalten, wer für Updates sorgt und wie schnell sicherheitsrelevante Patches eingespielt werden müssen. Die Einhaltung solcher Pflichten schützt nicht nur vor Unfällen, sondern kann im Haftungsfall zeigen, dass man seiner Sorgfalt nachgekommen ist.

- Compliance-Systeme und AI Act: Die kommende EU-KI-Verordnung (AI Act) wird für bestimmte KI-Systeme, besonders Hochrisiko-Anwendungen, strenge Compliance-Vorgaben machen – von Risikobewertungen über Transparenz bis hin zu Benutzerhinweisen. Unternehmen sollten sich frühzeitig darauf einstellen und interne Compliance-Systeme aufbauen, die diese Anforderungen erfüllen. Dazu gehört auch, klare Verantwortliche (KI-Compliance-Officer) zu benennen. Datenschutzvorgaben müssen ebenso integriert werden, um beispielsweise Fehlfunktionen, die zu Datenpannen führen, vorzubeugen – siehe hierzu auch unsere Ausführungen zu Datenschutzrisiken beim KI-Training im Beitrag „Datentraining mit Kundendaten – Wann droht ein DSGVO-Schaden?“.

Ein oft übersehener Aspekt der Prävention ist zudem die Auswahl und Schulung der Mitarbeiter: Teams sollten genau wissen, wie die KI arbeitet, wo ihre Grenzen liegen und was im Fehlerfall zu tun ist. Definierte Notfallpläne (etwa das manuelle Abschalten eines Systems bei Auffälligkeiten) können Leben retten und Haftungsansprüche minimieren.

Fazit – Neue Haftung braucht neue Beweise

Mit dem Vormarsch autonomer Systeme verschiebt sich die Haftung weg vom direkten menschlichen Fehlverhalten hin zur Haftung für Technik. Für Unternehmen bedeutet das: Beweislast und Verantwortung verlagern sich stärker auf den Hersteller und Betreiber der KI. Wer nachweisen kann, dass er alle vorgeschriebenen und zumutbaren Sicherheitsvorkehrungen getroffen hat, wird im Ernstfall deutlich besser dastehen. Künftig wird die Dokumentation jeder sicherheitsrelevanten Entscheidung und die lückenlose Protokollierung des Systemverhaltens zentral sein, um sich zu exkulpieren.

Die Rechtslandschaft passt sich langsam an – von der Produkthaftung bis zum AI Act – doch schon jetzt sollten Unternehmen nicht auf gesetzliche Klarheit warten, sondern proaktiv handeln. Neue Haftungsregeln erfordern ein Umdenken: Weg von „blindem Vertrauen“ in die Technologie, hin zu „accountable AI“, bei der menschliche Aufsicht, Nachvollziehbarkeit und kontinuierliche Verbesserung fest verankert sind. Nur so kann man die Chancen der KI nutzen, ohne an ihren Risiken zu scheitern.

Call-to-Action (CTA mit passenden Verlinkungen)

Wenn KI entscheidet, braucht Verantwortung neue Maßstäbe.

Autonome Systeme, die ohne menschlichen Eingriff handeln, stellen klassische Haftungsmodelle infrage.

Doch Recht bleibt nicht stehen – es verlagert die Beweislast. Und wer nicht dokumentiert, verliert.

Lesen Sie weiter:

Künstliche Intelligenz (KI) und Digitales Recht

Die rasante Entwicklung von KI-Systemen stellt Recht und Gesellschaft vor neue Herausforderungen. Ob Produkthaftung, Datenschutz, Urheberrecht oder regulatorische Anforderungen wie der AI Act – wir beraten Unternehmen und Entwickler bei der rechtssicheren Gestaltung und dem verantwortungsvollen Einsatz von KI-Technologien.

- A bis Z für Digital Creator: Die wichtigsten Red Flags und wie du sie vermeidest (Teil 2)

https://www.hortmannlaw.com/articles/vertragsfallen-fur-musiker - AI Act Zertifizierungspflicht

https://www.hortmannlaw.com/articles/ai-act-zertifizierungspflicht - Abmahnwelle durch KI-generierte Inhalte

https://www.hortmannlaw.com/articles/abmahnwelle-durch-ki-generierte-inhalte - Coldmailing legal absichern – So bleiben Kaltakquise-E-Mails rechtskonform

https://www.hortmannlaw.com/articles/coldmailing-legal-absichern - Dataset-Governance & Auditfähigkeit: Rechtssicherheit im KI-Training

https://www.hortmannlaw.com/articles/dataset-governance-auditfahigkeit-rechtssicherheit-im-ki-training - Exklusivitätsklauseln in Modelverträgen

https://www.hortmannlaw.com/articles/exklusivitatsklauseln-in-modelvertragen - Fehlfunktionen von KI-Systemen als Haftungsfalle

https://www.hortmannlaw.com/articles/fehlfunktionen-von-ki-systemen-als-haftungsfalle - Finanzierung & Kapitalbeschaffung für KI-Start-ups

https://www.hortmannlaw.com/articles/finanzierung-kapitalbeschaffung-ki-start-ups - Gesellschaftsformen und Gründung von KI-Start-ups: Ein Leitfaden für Gründer

https://www.hortmannlaw.com/articles/grundung-ki-startup - Haftung und Compliance im KI-Bereich

https://www.hortmannlaw.com/articles/haftung-und-compliance-im-kl-bereich - Internationale Expansion von KI-Start-ups: Rechtliche Fallstricke und Chancen

https://www.hortmannlaw.com/articles/internationale-expansion-ki - KI Musikrecht in der Praxis

https://www.hortmannlaw.com/articles/ki-musikrecht-praxis - KI und Recht - Trainingsdaten, Produkthaftung und Einsatz im Unternehmen

https://www.hortmannlaw.com/articles/ki-und-recht-trainingsdaten-produkthaftung-und-einsatz-im-unternehmen - KI-Spezial – Teil II – Fragmentierte Kontrolle – juristische Resonanzarchitektur gegen maschinelle Lesbarkeit

https://www.hortmannlaw.com/articles/ki-spezial-teil-ii-internationale-erbengemeinschaften-typische-nachlassprobleme-bei-grenzuberschreitender-abwicklung - KI-Vertragspflichten in Agenturen – Wer haftet für automatisierte Fehler?

https://www.hortmannlaw.com/articles/ki-vertragspflichten-in-agenturen - Risikoklassen im AI Act – Überblick und Bedeutung für Unternehmen

https://www.hortmannlaw.com/articles/risikoklassen-im-ai-act-uberblick-und-bedeutung-fur-unternehmen - Schadensersatz & Unterlassung bei Online-Rechtsverletzungen – Zivilrechtliche Optionen neben der Strafanzeige

https://www.hortmannlaw.com/articles/schadensersatz-und-unterlassung-online-rechtsverletzungen - Urheberrecht & KI-Training: Schranken, Lizenzen und Opt-out

https://www.hortmannlaw.com/articles/urheberrecht-ki-training-schranken-lizenzen-und-opt-out

Sie wollen Haftung vermeiden, bevor ein Fehler passiert?

Wir prüfen Ihre KI-Modelle, Ihre Verträge und Ihre Compliance-Struktur.

👉 Jetzt Kontakt aufnehmen

Das könnte Sie auch interessieren

Entdecken Sie weitere Beiträge zu aktuellen Themen rund um Digitalrecht, Cybercrime, Datenschutz, KI und Steuerrecht. Unsere verwandten Artikel geben Ihnen zusätzliche Einblicke und vertiefende Analysen.

.jpg)

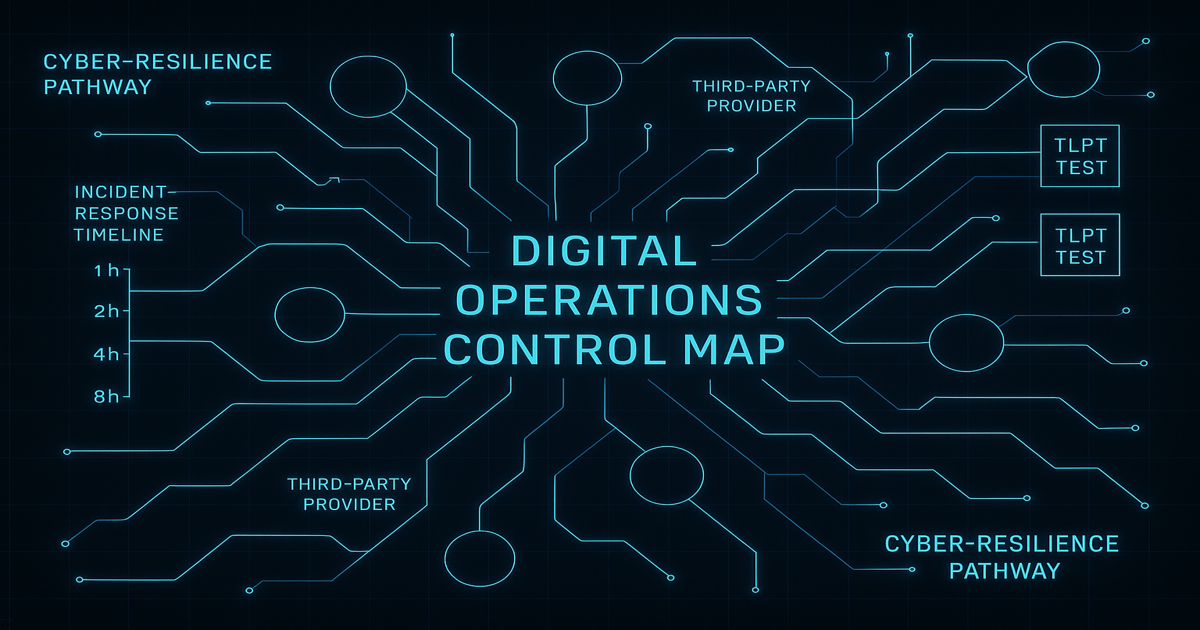

DORA für Krypto 2025: Anwalt erklärt Token-, CASP- & Outsourcing-Pflichten

DORA verlangt von Krypto-Anbietern einheitliche Incident-Meldungen, Red-Team-Tests, IKT-Risikomanagement und strenge Cloud-Governance. Der Beitrag zeigt, welche Pflichten für Token-Emittenten, CASPs und Plattformbetreiber 2025 verbindlich werden.

.jpg)

Organhaftung 2025: Anwalt erklärt MiCA-, KMAG- & DORA-Pflichten für Krypto und Token

MiCA, KMAG und DORA schaffen erstmals eine umfassende persönliche Haftung für Geschäftsleiter im Krypto-Sektor. Fehler bei Whitepaper, Governance oder IT-Sicherheit führen zu individuellen Sanktionen, Bußgeldern oder Berufsverboten. Der Beitrag zeigt Pflichten und Schutzstrategien.

.jpg)

ART-Token 2025: Anwalt erklärt Governance, Preisstabilität & Krypto-Haftung

Asset-referenced Tokens erfordern robuste Governance, Preisstabilitätsmechanismen und Oracle-Sicherheit. MiCA macht Emittenten persönlich verantwortlich für Stabilität, Updates und Markttransparenz. Der Beitrag zeigt Risiken, Haftung und Compliance-Strukturen.

Suchen Sie dringend diskrete, juristische Unterstüzung?

Wir helfen Ihnen gerne persönlich weiter – schildern Sie uns Ihr Anliegen und wir finden gemeinsam eine Lösung.